搜索到

88

篇与

的结果

-

kafka常用命令 topic 相关说明:红色的是必需要指定的参数使用bin/kafka-topics.sh 可查看所有的参数信息参数描述--bootstrap-server <String: server connect to> 连接kafka broker主机名称和端口号--topic <String: topic> 操作的topic名称--create创建主题--delete删除主题--alter修改主题--list查看所有主题--describe查看主题详细描述--partitions <Integer: # of partitions>设置分区数--replication-factor <Integer: replication factor>设置分区副本--config <String: name=value>更新系统默认的配置root@kf1:/opt/kafka# bin/kafka-topics.sh --bootstrap-server kf1:9092 --describe --topic first Topic: first TopicId: o4AxZZfwQhG-QR38nHUGxQ PartitionCount: 3 ReplicationFactor: 3 Configs: min.insync.replicas=1,segment.bytes=1073741824 Topic: first Partition: 0 Leader: 1 Replicas: 1,2,3 Isr: 1,2,3 Elr: LastKnownElr: Topic: first Partition: 1 Leader: 2 Replicas: 2,3,1 Isr: 2,3,1 Elr: LastKnownElr: Topic: first Partition: 2 Leader: 3 Replicas: 3,1,2 Isr: 3,1,2 Elr: LastKnownElr: Topic: 主题名称TopicId: 主题IDPartitionCount: 分区数量ReplicationFactor: 副本数量Configs: min.insync.replicas=1,segment.bytes=1073741824Topic:Partition: 分区IDLeader: 副本的leaderReplicas: 副本存储位置Isr: 连接的副本LastKnownElr

kafka常用命令 topic 相关说明:红色的是必需要指定的参数使用bin/kafka-topics.sh 可查看所有的参数信息参数描述--bootstrap-server <String: server connect to> 连接kafka broker主机名称和端口号--topic <String: topic> 操作的topic名称--create创建主题--delete删除主题--alter修改主题--list查看所有主题--describe查看主题详细描述--partitions <Integer: # of partitions>设置分区数--replication-factor <Integer: replication factor>设置分区副本--config <String: name=value>更新系统默认的配置root@kf1:/opt/kafka# bin/kafka-topics.sh --bootstrap-server kf1:9092 --describe --topic first Topic: first TopicId: o4AxZZfwQhG-QR38nHUGxQ PartitionCount: 3 ReplicationFactor: 3 Configs: min.insync.replicas=1,segment.bytes=1073741824 Topic: first Partition: 0 Leader: 1 Replicas: 1,2,3 Isr: 1,2,3 Elr: LastKnownElr: Topic: first Partition: 1 Leader: 2 Replicas: 2,3,1 Isr: 2,3,1 Elr: LastKnownElr: Topic: first Partition: 2 Leader: 3 Replicas: 3,1,2 Isr: 3,1,2 Elr: LastKnownElr: Topic: 主题名称TopicId: 主题IDPartitionCount: 分区数量ReplicationFactor: 副本数量Configs: min.insync.replicas=1,segment.bytes=1073741824Topic:Partition: 分区IDLeader: 副本的leaderReplicas: 副本存储位置Isr: 连接的副本LastKnownElr -

Kafka——Kafka安装(kafka_2.13-4.1.1) kafka2.8.0版本引入了基于Raft共识协议的新特性,它允许kafka集群在没有ZooKeeper的情况下运行。为了剥离和去除ZooKeeper,Kafka引入了自己的KRaft(Kafka Raft Metadata Mode)。KRaft是一个新的元数据管理架构,基于Raft一致性算法实现的一种内置元数据管理方式,旨在替代ZooKeeper的元数据管理功能。KRaft的优势有以下几点:简化部署:Kafka 集群不再依赖外部的 ZooKeeper 集群,简化了部署和运维的复杂性。KRaft 将所有协调服务嵌入 Kafka 自身,不再依赖外部系统,这样大大简化了部署和管理,因为管理员只需关注 Kafka 集群。高效的一致性协议:Raft 是一种简洁且易于理解的一致性算法,易于调试和实现。KRaft 利用 Raft 协议实现了强一致性的元数据管理,优化了复制机制。提高性能:由于元数据管理不再依赖 ZooKeeper,Kafka 集群的性能得到了提升,尤其是在元数据读写方面。增强可扩展性:KRaft 模式支持更大的集群规模,可以有效地扩展到数百万个分区。提高元数据操作的扩展性:新的架构允许更多的并发操作,并减少了因为扩展性问题导致的瓶颈,特别是在高负载场景中。更快的控制器故障转移:控制器(Controller)的选举和故障转移速度更快,提高了集群的稳定性。消除 ZooKeeper 作为中间层之后,Kafka 的延迟性能有望得到改善,特别是在涉及选主和元数据更新的场景中。KRaft模式下,kafka集群中的一些节点被指定为控制器(Controller),它们负责集群的元数据管理和共识服务,所有的元数据都存储在kafka内部的主题中,而不是ZooKeeper,控制器通过KRaft协议来确保元数据在集群中的准确复制,这种模式使用了基于时间的存储模型,通过定期快照来保证元数据日志不会无限增长。完全自主:因为是自家产品,所以产品的架构设计,代码开发都可以自己说了算,未来架构走向完全控制在自己手上。控制器(Controller)节点的去中心化:KRaft 模式中,控制器节点由一组 Kafka 服务进程代替,而不是一个独立的 ZooKeeper 集群。这些节点共同负责管理集群的元数据,通过 Raft 实现数据的一致性。日志复制和恢复机制:利用 Raft 的日志复制和状态机应用机制,KRaft 实现了对元数据变更的强一致性支持,这意味着所有控制器节点都能够就集群状态达成共识。动态集群管理:KRaft允许动态地向集群中添加或移除节点,而无需手动去ZooKeeper中更新配置,这使得集群管理更为便捷。下载在 kakfa官网 下载最新的安装包,推荐下载已经编译好的二进制包。wget https://dlcdn.apache.org/kafka/4.1.1/kafka_2.13-4.1.1.tgz tar -xzf kafka_2.13-4.1.1.tgz mv kafka_2.13-4.1.1 /opt/kafka修改配置文件修改位于config目录下的server.properties############################# Server Basics ############################# #定义节点角色。broker,处理消息存储、生产者/消费者请求;controller,管理集群元数据(分区状态、副本分配)。 process.roles=broker,controller # 节点id,要求集群内唯一,每个节点的id都要不同(如 1、2、3)。 node.id=1 #Controller节点启动时发现的初始服务器列表(用于加入集群)。 controller.quorum.bootstrap.servers=kf1:9093,kf2:9093,kf3:9093 #controller集群成员列表,集群内部选举和同步元数据,所有 Controller 节点必须在此列表中,且数量需满足多数派(如 3 节点集群需至少 2 个在线)。 controller.quorum.voters=1@kf1:9093,2@kf2:9093,3@kf3:9093 ############################# Socket Server Settings ##################### #节点绑定的网络接口和端口。PLAINTEXT:Broker服务端口(接收客户端请求),CONTROLLER:Controller间通信端口。 listeners=PLAINTEXT://0.0.0.0:9092,CONTROLLER://0.0.0.0:9093 #Broker 之间通信使用的监听器名称 inter.broker.listener.name=PLAINTEXT #客户端实际连接的地址(Broker 会返回此地址给客户端)。 advertised.listeners=PLAINTEXT://192.168.88.51:9092,CONTROLLER://192.168.88.51:9093 #Controller 节点间通信使用的监听器名称 controller.listener.names=CONTROLLER #监听器名称与安全协议的映射关系。 listener.security.protocol.map=CONTROLLER:PLAINTEXT,PLAINTEXT:PLAINTEXT,SSL:SSL,SASL_PLAINTEXT:SASL_PLAINTEXT,SASL_SSL:SASL_SSL #处理网络请求的线程数(如接收请求、发送响应)。 num.network.threads=3 #处理磁盘 I/O 的线程数(如读写日志文件)。 num.io.threads=8 #Socket 缓冲区 socket.send.buffer.bytes=102400 #发送数据缓冲区大小(100KB)。 socket.receive.buffer.bytes=102400 #接收数据缓冲区大小(100KB)。 socket.request.max.bytes=104857600 #请求最大长度(100MB),防止 OOM。 ############################# Log Basics ############################# #消息日志存储目录(可配置多个路径,逗号分隔)。 log.dirs=/opt/kafka_data # 日志目录(可选) kafka_logs_dir=/var/log/kafka #分区与恢复 num.partitions=3 #新建 Topic 的默认分区数。 num.recovery.threads.per.data.dir=1 #每个日志目录用于崩溃恢复的线程数。 ############################# Internal Topic Settings #################### #副本因子与 ISR offsets.topic.replication.factor=3 # __consumer_offsets 副本数(生产环境建议 ≥3) share.coordinator.state.topic.replication.factor=2 # Share Group 状态主题副本数 share.coordinator.state.topic.min.isr=2 #share.coordinator.state.topic:Kafka Share Group 协调器的状态主题(内部主题)。min.isr:最小同步副本数(Minimum In-Sync Replicas),即写入操作需确认的最小同步副本数量(含 Leader)。配置值 1:表示向 share.coordinator.state.topic写入数据时,只需 Leader 副本确认即可认为成功(无需等待 Follower 副本同步)。逻辑:ISR(In-Sync Replicas,同步副本集)是 Leader 副本及与其保持同步的 Follower 副本的集合。min.isr=1意味着只要 Leader 副本存活且可写,写入就成功(即使没有其他同步副本)。 transaction.state.log.replication.factor=3 #transaction.state.log:Kafka 事务协调器的状态日志主题。事务协调器负责管理分布式事务(如跨分区/主题的事务提交/中止),该主题存储事务元数据(如事务 ID、参与者列表、状态(进行中/已提交/已中止)、超时时间等)。replication.factor:副本因子,即主题每个分区的副本总数(含 Leader 副本)。配置值 1:表示 transaction.state.log的每个分区仅有 1 个副本(仅 Leader 副本,无 Follower 副本)。逻辑:副本因子决定数据冗余度。replication.factor=1意味着数据仅存储在单个 Broker 上,无任何备份。 transaction.state.log.min.isr=3 #transaction.state.log:指定该参数作用于 事务状态日志(而非普通业务 Topic)。min.isr:即“最小同步副本数”,表示事务状态日志的每个分区,必须至少有 N 个副本(包括 Leader 副本)与 Leader 保持同步,否则该分区会进入“不可用”状态(无法写入新事务记录)。当事务状态日志的某个分区进行写入时,Kafka 会确保该分区的 同步副本集(ISR)大小 ≥ 3。只有当至少 3 个副本(Leader + 2 个 Follower)都成功复制了事务日志条目后,才会向生产者返回“事务提交成功”的响应。 default.replication.factor=3 #普通主题默认的副本因子数量 ############################# Log Flush Policy ############################ #日志保留策略 log.retention.hours=168 #日志保留时间(168 小时 = 7 天)。 log.segment.bytes=1073741824 #单个日志分段大小(1GB),达到后滚动生成新文件。 log.retention.check.interval.ms=300000 #检查日志保留的间隔(5 分钟)。在节点2上修改node.id=2 advertised.listeners=PLAINTEXT://192.168.88.52:9092,CONTROLLER://192.168.88.52:9093在节点3上修改node.id=3 advertised.listeners=PLAINTEXT://192.168.88.53:9092,CONTROLLER://192.168.88.53:9093初始化集群并启动首次启动时执行#在任一节点执行,仅执行一次,生成唯一集群ID bin/kafka-storage.sh random-uuid 0jQIB8NvQ3muEJg2vXIRRA #在每个节点执行,格式化存储 bin/kafka-storage.sh format -t 0jQIB8NvQ3muEJg2vXIRRA -c config/server.propertie Formatting metadata directory /opt/kafka_data with metadata.version 4.1-IV1.启动服务配置开机自启创建service文件vim /etc/systemd/system/kafka.service [Unit] Description=Apache Kafka Server Documentation=http://kafka.apache.org/documentation.html Requires=network.target remote-fs.target After=network.target remote-fs.target [Service] Type=simple User=kafka Group=kafka ExecStart=/opt/kafka/bin/kafka-server-start.sh /opt/kafka/config/server.properties ExecStop=/opt/kafka/bin/kafka-server-stop.sh Restart=on-abnormal RestartSec=10 KillMode=mixed TimeoutStopSec=30 Environment="LOG_DIR=/var/log/kafka" Environment="KAFKA_HEAP_OPTS=-Xmx1G -Xms1G" # 显式设置堆内存 # 日志重定向 StandardOutput=file:/var/log/kafka/service.log StandardError=file:/var/log/kafka/service-error.log [Install] WantedBy=multi-user.target# 重载 systemd 配置 sudo systemctl daemon-reload创建 Kafka 专用用户和目录# 创建系统用户 sudo useradd -r -s /sbin/nologin kafka # 创建数据/日志目录 sudo mkdir -p /opt/kafka_data sudo mkdir -p /var/log/kafka sudo chown -R kafka:kafka /opt/kafka_data /var/log/kafka # 授权 Kafka 安装目录 sudo chown -R kafka:kafka /opt/kafka按顺序启动节点可以使用systemctl命令或者手动的方式启动服务,#systemctl启动 systemctl enable --now kafka #前台启动 bin/kafka-server-start.sh config/server.properties #后台启动 nohup bin/kafka-server-start.sh config/server.properties &查看集群状态bin/kafka-broker-api-versions.sh --bootstrap-server 127.0.0.1:9092 # 192.168.88.51:9092 Broker 对外提供服务的 IP:端口(客户端实际连接的地址)。 #id: 1 Broker 的唯一标识 broker.id(集群中必须唯一,此处为 1、2、3)。 # rack: null 机架信息(未配置,故为 null,用于副本跨机架分布策略)。 #isFenced: false Broker 未被“隔离”(正常工作状态,若为 true则无法处理请求)。 192.168.88.51:9092 (id: 1 rack: null isFenced: false) -> ( Produce(0): 0 to 13 [usable: 13], #Produce(0) API 名称(Produce,消息生产 API),括号内 0是该 API 的 固定 key(Kafka 定义)。 #0 to 13 该 API 支持的 版本范围(从 v0 到 v13,共 14 个版本)。 #usable: 13 客户端与 Broker 协商后 实际使用的版本(取双方都支持的最高版本,性能最优)。 Fetch(1): 4 to 18 [usable: 18], ListOffsets(2): 1 to 10 [usable: 10], Metadata(3): 0 to 13 [usable: 13], OffsetCommit(8): 2 to 9 [usable: 9], OffsetFetch(9): 1 to 9 [usable: 9], FindCoordinator(10): 0 to 6 [usable: 6], JoinGroup(11): 0 to 9 [usable: 9], Heartbeat(12): 0 to 4 [usable: 4], LeaveGroup(13): 0 to 5 [usable: 5], SyncGroup(14): 0 to 5 [usable: 5], DescribeGroups(15): 0 to 6 [usable: 6], ListGroups(16): 0 to 5 [usable: 5], SaslHandshake(17): 0 to 1 [usable: 1], ApiVersions(18): 0 to 4 [usable: 4], CreateTopics(19): 2 to 7 [usable: 7], DeleteTopics(20): 1 to 6 [usable: 6], DeleteRecords(21): 0 to 2 [usable: 2], InitProducerId(22): 0 to 5 [usable: 5], OffsetForLeaderEpoch(23): 2 to 4 [usable: 4], AddPartitionsToTxn(24): 0 to 5 [usable: 5], AddOffsetsToTxn(25): 0 to 4 [usable: 4], EndTxn(26): 0 to 5 [usable: 5], WriteTxnMarkers(27): 1 [usable: 1], TxnOffsetCommit(28): 0 to 5 [usable: 5], DescribeAcls(29): 1 to 3 [usable: 3], CreateAcls(30): 1 to 3 [usable: 3], DeleteAcls(31): 1 to 3 [usable: 3], DescribeConfigs(32): 1 to 4 [usable: 4], AlterConfigs(33): 0 to 2 [usable: 2], AlterReplicaLogDirs(34): 1 to 2 [usable: 2], DescribeLogDirs(35): 1 to 4 [usable: 4], SaslAuthenticate(36): 0 to 2 [usable: 2], CreatePartitions(37): 0 to 3 [usable: 3], CreateDelegationToken(38): 1 to 3 [usable: 3], RenewDelegationToken(39): 1 to 2 [usable: 2], ExpireDelegationToken(40): 1 to 2 [usable: 2], DescribeDelegationToken(41): 1 to 3 [usable: 3], DeleteGroups(42): 0 to 2 [usable: 2], ElectLeaders(43): 0 to 2 [usable: 2], IncrementalAlterConfigs(44): 0 to 1 [usable: 1], AlterPartitionReassignments(45): 0 to 1 [usable: 1], ListPartitionReassignments(46): 0 [usable: 0], OffsetDelete(47): 0 [usable: 0], DescribeClientQuotas(48): 0 to 1 [usable: 1], AlterClientQuotas(49): 0 to 1 [usable: 1], DescribeUserScramCredentials(50): 0 [usable: 0], AlterUserScramCredentials(51): 0 [usable: 0], DescribeQuorum(55): 0 to 2 [usable: 2], UpdateFeatures(57): 0 to 2 [usable: 2], DescribeCluster(60): 0 to 2 [usable: 2], DescribeProducers(61): 0 [usable: 0], UnregisterBroker(64): 0 [usable: 0], DescribeTransactions(65): 0 [usable: 0], ListTransactions(66): 0 to 2 [usable: 2], ConsumerGroupHeartbeat(68): 0 to 1 [usable: 1], ConsumerGroupDescribe(69): 0 to 1 [usable: 1], GetTelemetrySubscriptions(71): UNSUPPORTED, PushTelemetry(72): UNSUPPORTED, ListConfigResources(74): 0 to 1 [usable: 1], DescribeTopicPartitions(75): 0 [usable: 0], ShareGroupHeartbeat(76): 1 [usable: 1], ShareGroupDescribe(77): 1 [usable: 1], ShareFetch(78): 1 [usable: 1], ShareAcknowledge(79): 1 [usable: 1], AddRaftVoter(80): 0 [usable: 0], RemoveRaftVoter(81): 0 [usable: 0], InitializeShareGroupState(83): 0 [usable: 0], ReadShareGroupState(84): 0 [usable: 0], WriteShareGroupState(85): 0 [usable: 0], DeleteShareGroupState(86): 0 [usable: 0], ReadShareGroupStateSummary(87): 0 [usable: 0], StreamsGroupHeartbeat(88): UNSUPPORTED, StreamsGroupDescribe(89): UNSUPPORTED, DescribeShareGroupOffsets(90): 0 [usable: 0], AlterShareGroupOffsets(91): 0 [usable: 0], DeleteShareGroupOffsets(92): 0 [usable: 0] ) 192.168.88.52:9092 (id: 2 rack: null isFenced: false) -> ( …… ) 192.168.88.53:9092 (id: 3 rack: null isFenced: false) -> ( …… )

Kafka——Kafka安装(kafka_2.13-4.1.1) kafka2.8.0版本引入了基于Raft共识协议的新特性,它允许kafka集群在没有ZooKeeper的情况下运行。为了剥离和去除ZooKeeper,Kafka引入了自己的KRaft(Kafka Raft Metadata Mode)。KRaft是一个新的元数据管理架构,基于Raft一致性算法实现的一种内置元数据管理方式,旨在替代ZooKeeper的元数据管理功能。KRaft的优势有以下几点:简化部署:Kafka 集群不再依赖外部的 ZooKeeper 集群,简化了部署和运维的复杂性。KRaft 将所有协调服务嵌入 Kafka 自身,不再依赖外部系统,这样大大简化了部署和管理,因为管理员只需关注 Kafka 集群。高效的一致性协议:Raft 是一种简洁且易于理解的一致性算法,易于调试和实现。KRaft 利用 Raft 协议实现了强一致性的元数据管理,优化了复制机制。提高性能:由于元数据管理不再依赖 ZooKeeper,Kafka 集群的性能得到了提升,尤其是在元数据读写方面。增强可扩展性:KRaft 模式支持更大的集群规模,可以有效地扩展到数百万个分区。提高元数据操作的扩展性:新的架构允许更多的并发操作,并减少了因为扩展性问题导致的瓶颈,特别是在高负载场景中。更快的控制器故障转移:控制器(Controller)的选举和故障转移速度更快,提高了集群的稳定性。消除 ZooKeeper 作为中间层之后,Kafka 的延迟性能有望得到改善,特别是在涉及选主和元数据更新的场景中。KRaft模式下,kafka集群中的一些节点被指定为控制器(Controller),它们负责集群的元数据管理和共识服务,所有的元数据都存储在kafka内部的主题中,而不是ZooKeeper,控制器通过KRaft协议来确保元数据在集群中的准确复制,这种模式使用了基于时间的存储模型,通过定期快照来保证元数据日志不会无限增长。完全自主:因为是自家产品,所以产品的架构设计,代码开发都可以自己说了算,未来架构走向完全控制在自己手上。控制器(Controller)节点的去中心化:KRaft 模式中,控制器节点由一组 Kafka 服务进程代替,而不是一个独立的 ZooKeeper 集群。这些节点共同负责管理集群的元数据,通过 Raft 实现数据的一致性。日志复制和恢复机制:利用 Raft 的日志复制和状态机应用机制,KRaft 实现了对元数据变更的强一致性支持,这意味着所有控制器节点都能够就集群状态达成共识。动态集群管理:KRaft允许动态地向集群中添加或移除节点,而无需手动去ZooKeeper中更新配置,这使得集群管理更为便捷。下载在 kakfa官网 下载最新的安装包,推荐下载已经编译好的二进制包。wget https://dlcdn.apache.org/kafka/4.1.1/kafka_2.13-4.1.1.tgz tar -xzf kafka_2.13-4.1.1.tgz mv kafka_2.13-4.1.1 /opt/kafka修改配置文件修改位于config目录下的server.properties############################# Server Basics ############################# #定义节点角色。broker,处理消息存储、生产者/消费者请求;controller,管理集群元数据(分区状态、副本分配)。 process.roles=broker,controller # 节点id,要求集群内唯一,每个节点的id都要不同(如 1、2、3)。 node.id=1 #Controller节点启动时发现的初始服务器列表(用于加入集群)。 controller.quorum.bootstrap.servers=kf1:9093,kf2:9093,kf3:9093 #controller集群成员列表,集群内部选举和同步元数据,所有 Controller 节点必须在此列表中,且数量需满足多数派(如 3 节点集群需至少 2 个在线)。 controller.quorum.voters=1@kf1:9093,2@kf2:9093,3@kf3:9093 ############################# Socket Server Settings ##################### #节点绑定的网络接口和端口。PLAINTEXT:Broker服务端口(接收客户端请求),CONTROLLER:Controller间通信端口。 listeners=PLAINTEXT://0.0.0.0:9092,CONTROLLER://0.0.0.0:9093 #Broker 之间通信使用的监听器名称 inter.broker.listener.name=PLAINTEXT #客户端实际连接的地址(Broker 会返回此地址给客户端)。 advertised.listeners=PLAINTEXT://192.168.88.51:9092,CONTROLLER://192.168.88.51:9093 #Controller 节点间通信使用的监听器名称 controller.listener.names=CONTROLLER #监听器名称与安全协议的映射关系。 listener.security.protocol.map=CONTROLLER:PLAINTEXT,PLAINTEXT:PLAINTEXT,SSL:SSL,SASL_PLAINTEXT:SASL_PLAINTEXT,SASL_SSL:SASL_SSL #处理网络请求的线程数(如接收请求、发送响应)。 num.network.threads=3 #处理磁盘 I/O 的线程数(如读写日志文件)。 num.io.threads=8 #Socket 缓冲区 socket.send.buffer.bytes=102400 #发送数据缓冲区大小(100KB)。 socket.receive.buffer.bytes=102400 #接收数据缓冲区大小(100KB)。 socket.request.max.bytes=104857600 #请求最大长度(100MB),防止 OOM。 ############################# Log Basics ############################# #消息日志存储目录(可配置多个路径,逗号分隔)。 log.dirs=/opt/kafka_data # 日志目录(可选) kafka_logs_dir=/var/log/kafka #分区与恢复 num.partitions=3 #新建 Topic 的默认分区数。 num.recovery.threads.per.data.dir=1 #每个日志目录用于崩溃恢复的线程数。 ############################# Internal Topic Settings #################### #副本因子与 ISR offsets.topic.replication.factor=3 # __consumer_offsets 副本数(生产环境建议 ≥3) share.coordinator.state.topic.replication.factor=2 # Share Group 状态主题副本数 share.coordinator.state.topic.min.isr=2 #share.coordinator.state.topic:Kafka Share Group 协调器的状态主题(内部主题)。min.isr:最小同步副本数(Minimum In-Sync Replicas),即写入操作需确认的最小同步副本数量(含 Leader)。配置值 1:表示向 share.coordinator.state.topic写入数据时,只需 Leader 副本确认即可认为成功(无需等待 Follower 副本同步)。逻辑:ISR(In-Sync Replicas,同步副本集)是 Leader 副本及与其保持同步的 Follower 副本的集合。min.isr=1意味着只要 Leader 副本存活且可写,写入就成功(即使没有其他同步副本)。 transaction.state.log.replication.factor=3 #transaction.state.log:Kafka 事务协调器的状态日志主题。事务协调器负责管理分布式事务(如跨分区/主题的事务提交/中止),该主题存储事务元数据(如事务 ID、参与者列表、状态(进行中/已提交/已中止)、超时时间等)。replication.factor:副本因子,即主题每个分区的副本总数(含 Leader 副本)。配置值 1:表示 transaction.state.log的每个分区仅有 1 个副本(仅 Leader 副本,无 Follower 副本)。逻辑:副本因子决定数据冗余度。replication.factor=1意味着数据仅存储在单个 Broker 上,无任何备份。 transaction.state.log.min.isr=3 #transaction.state.log:指定该参数作用于 事务状态日志(而非普通业务 Topic)。min.isr:即“最小同步副本数”,表示事务状态日志的每个分区,必须至少有 N 个副本(包括 Leader 副本)与 Leader 保持同步,否则该分区会进入“不可用”状态(无法写入新事务记录)。当事务状态日志的某个分区进行写入时,Kafka 会确保该分区的 同步副本集(ISR)大小 ≥ 3。只有当至少 3 个副本(Leader + 2 个 Follower)都成功复制了事务日志条目后,才会向生产者返回“事务提交成功”的响应。 default.replication.factor=3 #普通主题默认的副本因子数量 ############################# Log Flush Policy ############################ #日志保留策略 log.retention.hours=168 #日志保留时间(168 小时 = 7 天)。 log.segment.bytes=1073741824 #单个日志分段大小(1GB),达到后滚动生成新文件。 log.retention.check.interval.ms=300000 #检查日志保留的间隔(5 分钟)。在节点2上修改node.id=2 advertised.listeners=PLAINTEXT://192.168.88.52:9092,CONTROLLER://192.168.88.52:9093在节点3上修改node.id=3 advertised.listeners=PLAINTEXT://192.168.88.53:9092,CONTROLLER://192.168.88.53:9093初始化集群并启动首次启动时执行#在任一节点执行,仅执行一次,生成唯一集群ID bin/kafka-storage.sh random-uuid 0jQIB8NvQ3muEJg2vXIRRA #在每个节点执行,格式化存储 bin/kafka-storage.sh format -t 0jQIB8NvQ3muEJg2vXIRRA -c config/server.propertie Formatting metadata directory /opt/kafka_data with metadata.version 4.1-IV1.启动服务配置开机自启创建service文件vim /etc/systemd/system/kafka.service [Unit] Description=Apache Kafka Server Documentation=http://kafka.apache.org/documentation.html Requires=network.target remote-fs.target After=network.target remote-fs.target [Service] Type=simple User=kafka Group=kafka ExecStart=/opt/kafka/bin/kafka-server-start.sh /opt/kafka/config/server.properties ExecStop=/opt/kafka/bin/kafka-server-stop.sh Restart=on-abnormal RestartSec=10 KillMode=mixed TimeoutStopSec=30 Environment="LOG_DIR=/var/log/kafka" Environment="KAFKA_HEAP_OPTS=-Xmx1G -Xms1G" # 显式设置堆内存 # 日志重定向 StandardOutput=file:/var/log/kafka/service.log StandardError=file:/var/log/kafka/service-error.log [Install] WantedBy=multi-user.target# 重载 systemd 配置 sudo systemctl daemon-reload创建 Kafka 专用用户和目录# 创建系统用户 sudo useradd -r -s /sbin/nologin kafka # 创建数据/日志目录 sudo mkdir -p /opt/kafka_data sudo mkdir -p /var/log/kafka sudo chown -R kafka:kafka /opt/kafka_data /var/log/kafka # 授权 Kafka 安装目录 sudo chown -R kafka:kafka /opt/kafka按顺序启动节点可以使用systemctl命令或者手动的方式启动服务,#systemctl启动 systemctl enable --now kafka #前台启动 bin/kafka-server-start.sh config/server.properties #后台启动 nohup bin/kafka-server-start.sh config/server.properties &查看集群状态bin/kafka-broker-api-versions.sh --bootstrap-server 127.0.0.1:9092 # 192.168.88.51:9092 Broker 对外提供服务的 IP:端口(客户端实际连接的地址)。 #id: 1 Broker 的唯一标识 broker.id(集群中必须唯一,此处为 1、2、3)。 # rack: null 机架信息(未配置,故为 null,用于副本跨机架分布策略)。 #isFenced: false Broker 未被“隔离”(正常工作状态,若为 true则无法处理请求)。 192.168.88.51:9092 (id: 1 rack: null isFenced: false) -> ( Produce(0): 0 to 13 [usable: 13], #Produce(0) API 名称(Produce,消息生产 API),括号内 0是该 API 的 固定 key(Kafka 定义)。 #0 to 13 该 API 支持的 版本范围(从 v0 到 v13,共 14 个版本)。 #usable: 13 客户端与 Broker 协商后 实际使用的版本(取双方都支持的最高版本,性能最优)。 Fetch(1): 4 to 18 [usable: 18], ListOffsets(2): 1 to 10 [usable: 10], Metadata(3): 0 to 13 [usable: 13], OffsetCommit(8): 2 to 9 [usable: 9], OffsetFetch(9): 1 to 9 [usable: 9], FindCoordinator(10): 0 to 6 [usable: 6], JoinGroup(11): 0 to 9 [usable: 9], Heartbeat(12): 0 to 4 [usable: 4], LeaveGroup(13): 0 to 5 [usable: 5], SyncGroup(14): 0 to 5 [usable: 5], DescribeGroups(15): 0 to 6 [usable: 6], ListGroups(16): 0 to 5 [usable: 5], SaslHandshake(17): 0 to 1 [usable: 1], ApiVersions(18): 0 to 4 [usable: 4], CreateTopics(19): 2 to 7 [usable: 7], DeleteTopics(20): 1 to 6 [usable: 6], DeleteRecords(21): 0 to 2 [usable: 2], InitProducerId(22): 0 to 5 [usable: 5], OffsetForLeaderEpoch(23): 2 to 4 [usable: 4], AddPartitionsToTxn(24): 0 to 5 [usable: 5], AddOffsetsToTxn(25): 0 to 4 [usable: 4], EndTxn(26): 0 to 5 [usable: 5], WriteTxnMarkers(27): 1 [usable: 1], TxnOffsetCommit(28): 0 to 5 [usable: 5], DescribeAcls(29): 1 to 3 [usable: 3], CreateAcls(30): 1 to 3 [usable: 3], DeleteAcls(31): 1 to 3 [usable: 3], DescribeConfigs(32): 1 to 4 [usable: 4], AlterConfigs(33): 0 to 2 [usable: 2], AlterReplicaLogDirs(34): 1 to 2 [usable: 2], DescribeLogDirs(35): 1 to 4 [usable: 4], SaslAuthenticate(36): 0 to 2 [usable: 2], CreatePartitions(37): 0 to 3 [usable: 3], CreateDelegationToken(38): 1 to 3 [usable: 3], RenewDelegationToken(39): 1 to 2 [usable: 2], ExpireDelegationToken(40): 1 to 2 [usable: 2], DescribeDelegationToken(41): 1 to 3 [usable: 3], DeleteGroups(42): 0 to 2 [usable: 2], ElectLeaders(43): 0 to 2 [usable: 2], IncrementalAlterConfigs(44): 0 to 1 [usable: 1], AlterPartitionReassignments(45): 0 to 1 [usable: 1], ListPartitionReassignments(46): 0 [usable: 0], OffsetDelete(47): 0 [usable: 0], DescribeClientQuotas(48): 0 to 1 [usable: 1], AlterClientQuotas(49): 0 to 1 [usable: 1], DescribeUserScramCredentials(50): 0 [usable: 0], AlterUserScramCredentials(51): 0 [usable: 0], DescribeQuorum(55): 0 to 2 [usable: 2], UpdateFeatures(57): 0 to 2 [usable: 2], DescribeCluster(60): 0 to 2 [usable: 2], DescribeProducers(61): 0 [usable: 0], UnregisterBroker(64): 0 [usable: 0], DescribeTransactions(65): 0 [usable: 0], ListTransactions(66): 0 to 2 [usable: 2], ConsumerGroupHeartbeat(68): 0 to 1 [usable: 1], ConsumerGroupDescribe(69): 0 to 1 [usable: 1], GetTelemetrySubscriptions(71): UNSUPPORTED, PushTelemetry(72): UNSUPPORTED, ListConfigResources(74): 0 to 1 [usable: 1], DescribeTopicPartitions(75): 0 [usable: 0], ShareGroupHeartbeat(76): 1 [usable: 1], ShareGroupDescribe(77): 1 [usable: 1], ShareFetch(78): 1 [usable: 1], ShareAcknowledge(79): 1 [usable: 1], AddRaftVoter(80): 0 [usable: 0], RemoveRaftVoter(81): 0 [usable: 0], InitializeShareGroupState(83): 0 [usable: 0], ReadShareGroupState(84): 0 [usable: 0], WriteShareGroupState(85): 0 [usable: 0], DeleteShareGroupState(86): 0 [usable: 0], ReadShareGroupStateSummary(87): 0 [usable: 0], StreamsGroupHeartbeat(88): UNSUPPORTED, StreamsGroupDescribe(89): UNSUPPORTED, DescribeShareGroupOffsets(90): 0 [usable: 0], AlterShareGroupOffsets(91): 0 [usable: 0], DeleteShareGroupOffsets(92): 0 [usable: 0] ) 192.168.88.52:9092 (id: 2 rack: null isFenced: false) -> ( …… ) 192.168.88.53:9092 (id: 3 rack: null isFenced: false) -> ( …… ) -

zookeeper安装 ZooKeeper 是一个分布式协调服务,常用于管理配置、命名和同步服务。长期以来,Kafka 使用 ZooKeeper 负责管理集群元数据、控制器选举和消费者组协调等任务理,包括主题、分区信息、ACL(访问控制列表)等。ZooKeeper 为 Kafka 提供了选主(leader election)、集群成员管理等核心功能,为 Kafka提供了一个可靠的分布式协调服务,使得 Kafka能够在多个节点之间进行有效的通信和管理。然而,随着 Kafka的发展,其对 ZooKeeper的依赖逐渐显露出一些问题,这些问题也是下面 Kafka去除 Zookeeper的原因。kafka 2.8+ 为什么要移除zookeeper组件呢?kafka 4.0+版本彻底移除了zookeeper组件1.复杂性增加ZooKeeper 是独立于 Kafka 的外部组件,需要单独部署和维护,因此,使用 ZooKeeper 使得 Kafka的运维复杂度大幅提升。运维团队必须同时管理两个分布式系统(Kafka和 ZooKeeper),这不仅增加了管理成本,也要求运维人员具备更高的技术能力。2. 性能瓶颈作为一个协调服务,ZooKeeper 并非专门为高负载场景设计, 因此,随着集群规模扩大,ZooKeeper在处理元数据时的性能问题日益突出。例如,当分区数量增加时,ZooKeeper需要存储更多的信息,这导致了监听延迟增加,从而影响Kafka的整体性能。在高负载情况下,ZooKeeper可能成为系统的瓶颈,限制了Kafka的扩展能力。3. 一致性问题Kafka 内部的分布式一致性模型与 ZooKeeper 的一致性模型有所不同。由于 ZooKeeper和 Kafka控制器之间的数据同步机制不够高效,可能导致状态不一致,特别是在处理集群扩展或不可用情景时,这种不一致性会影响消息传递的可靠性和系统稳定性。4.发展自己的生态Kafka 抛弃 ZooKeeper,最核心的原因:Kafka生态强大了,需要自立门户,这样就不会被别人卡脖子。纵观国内外,有很多这样鲜活的例子,当自己弱小时,会先选择使用别家的产品,当自己羽翼丰满时,再选择自建完善自己的生态圈。但是一些旧版的kafka仍需配置ZooKeeper服务,因为Kafka依赖ZooKeeper进行集群协调、Broker注册、Topic管理等操作。安装ZooKeeperJava环境ZooKeeper是基于Java开发的,因此在部署时需要确保机器上有Java运行环境(JRE/JDK)。检查当前 Java 环境首先确认系统是否已安装 Java,以及版本是否符合要求java -version openjdk version "25.0.1" 2025-10-21 OpenJDK Runtime Environment (build 25.0.1+8-Ubuntu-124.04) OpenJDK 64-Bit Server VM (build 25.0.1+8-Ubuntu-124.04, mixed mode, sharing)若提示 command not found,说明未安装 Java,需继续安装java -version 找不到命令 “java”,但可以通过以下软件包安装它: apt install openjdk-17-jre-headless # version 17.0.17+10-1~24.04, or apt install openjdk-21-jre-headless # version 21.0.9+10-1~24.04 apt install default-jre # version 2:1.17-75 apt install openjdk-19-jre-headless # version 19.0.2+7-4 apt install openjdk-20-jre-headless # version 20.0.2+9-1 apt install openjdk-22-jre-headless # version 22~22ea-1 apt install openjdk-11-jre-headless # version 11.0.29+7-1ubuntu1~24.04 apt install openjdk-25-jre-headless # version 25.0.1+8-1~24.04 apt install openjdk-8-jre-headless # version 8u472-ga-1~24.04 root@zookeeper1:~/zookeeper# apt install openjdk-11-jre-headless 正在读取软件包列表... 完成 正在分析软件包的依赖关系树... 完成 正在读取状态信息... 完成 将会同时安装下列软件: alsa-topology-conf alsa-ucm-conf ca-certificates-java java-common libasound2-data libasound2t64 建议安装: default-jre alsa-utils libasound2-plugins libnss-mdns fonts-dejavu-extra fonts-ipafont-gothic fonts-ipafont-mincho fonts-wqy-microhei | fonts-wqy-zenhei fonts-indic下载并解压ZooKeeper点击 ZooKeeper下载列表 ,下载最新版本的安装包。wget -O zookeeper-3.9.4-bin.tar.gz https://dlcdn.apache.org/zookeeper/zookeeper-3.9.4/apache-zookeeper-3.9.4-bin.tar.gz tar -xf zookeeper-3.9.4-bin.tar.gz mv apache-zookeeper-3.9.4-bin/ /opt/zookeeper注意:集群模式至少需要三台服务器,强烈建议拥有奇数台服务器。如果你只有两台服务器,那么如果其中一台故障,机器数量不足以形成多数法定人数。两台服务器本质上比单台服务器稳定性差,因为存在两个单点故障。配置所有的服务器都拥有相同的配置文件。在ZooKeeper目录下的conf目录中,有个配置文件的示例,拷贝这个文件并修改其中的部分内容cp conf/zoo_sample.cfg conf/zoo.cfg修改项:tickTime=2000 initLimit=10 syncLimit=5 dataDir=/var/zookeeper/data dataLogDir=/var/zookeeper/logs clientPort=2181 server.1=192.168.88.31:2888:3888 server.2=192.168.88.32:2888:3888 server.3=192.168.88.33:2888:3888说明:tickTime:ZooKeeper 使用的基本时间单位(毫秒)。它用于读取心跳,最小会话超时时间是tickTime的两倍。initLimit:用来限制法定人数服务器连接领导者所需时间的超时syncLimit:限制服务器与领导者的过时距离dataDir:存储内存数据库快照的位置,除非另有说明,存储数据库更新的事务日志。dataLogDir:存储日志文件的位置clientPort:用于监听客户端连接的端口server.1=192.168.88.31:2888:3888 集群地址,“2888”和“3888”。对等节点使用前一个端口连接其他节点。这种连接是必要的,以便对等端能够通信,例如达成更新顺序的一致。更具体地说,ZooKeeper服务器利用该端口将追随者连接到领导者。当出现新的领导者时,跟随者会通过该端口与该领导者开启TCP连接。由于默认领导人选举也使用TCP,我们目前要求领导人选举需要另一个端口。这是服务器条目的第二个端口。确保dataDir和dataLogDir目录存在,如果不存在就创建它们。配置myid 在data/目录下,按集群顺序依次创建myid文件并写入id信息。#88.31机器上 echo 1 >myid #88.32机器上 echo 2 >myid #88.33机器上 echo 3 >myid开启服务bin/zkServer.sh start /usr/bin/java ZooKeeper JMX enabled by default Using config: /root/zookeeper/bin/../conf/zoo.cfg Starting zookeeper ... STARTED root@zookeeper2:~/zookeeper# bin/zkServer.sh status /usr/bin/java ZooKeeper JMX enabled by default Using config: /root/zookeeper/bin/../conf/zoo.cfg Client port found: 2181. Client address: localhost. Client SSL: false. Mode: leader 配置开机启动(service服务)vim /etc/systemd/system/zookeeper.service [Unit] Description=Apache ZooKeeper Service Documentation=https://zookeeper.apache.org After=network.target [Service] Type=forking ExecStart=/root/zookeeper/bin/zkServer.sh start ExecStop=/root/zookeeper/bin/zkServer.sh stop ExecReload=/root/zookeeper/bin/zkServer.sh restart Restart=on-failure [Install] WantedBy=multi-user.target systemctl daemon-reload systemctl enable zookeeper --now

zookeeper安装 ZooKeeper 是一个分布式协调服务,常用于管理配置、命名和同步服务。长期以来,Kafka 使用 ZooKeeper 负责管理集群元数据、控制器选举和消费者组协调等任务理,包括主题、分区信息、ACL(访问控制列表)等。ZooKeeper 为 Kafka 提供了选主(leader election)、集群成员管理等核心功能,为 Kafka提供了一个可靠的分布式协调服务,使得 Kafka能够在多个节点之间进行有效的通信和管理。然而,随着 Kafka的发展,其对 ZooKeeper的依赖逐渐显露出一些问题,这些问题也是下面 Kafka去除 Zookeeper的原因。kafka 2.8+ 为什么要移除zookeeper组件呢?kafka 4.0+版本彻底移除了zookeeper组件1.复杂性增加ZooKeeper 是独立于 Kafka 的外部组件,需要单独部署和维护,因此,使用 ZooKeeper 使得 Kafka的运维复杂度大幅提升。运维团队必须同时管理两个分布式系统(Kafka和 ZooKeeper),这不仅增加了管理成本,也要求运维人员具备更高的技术能力。2. 性能瓶颈作为一个协调服务,ZooKeeper 并非专门为高负载场景设计, 因此,随着集群规模扩大,ZooKeeper在处理元数据时的性能问题日益突出。例如,当分区数量增加时,ZooKeeper需要存储更多的信息,这导致了监听延迟增加,从而影响Kafka的整体性能。在高负载情况下,ZooKeeper可能成为系统的瓶颈,限制了Kafka的扩展能力。3. 一致性问题Kafka 内部的分布式一致性模型与 ZooKeeper 的一致性模型有所不同。由于 ZooKeeper和 Kafka控制器之间的数据同步机制不够高效,可能导致状态不一致,特别是在处理集群扩展或不可用情景时,这种不一致性会影响消息传递的可靠性和系统稳定性。4.发展自己的生态Kafka 抛弃 ZooKeeper,最核心的原因:Kafka生态强大了,需要自立门户,这样就不会被别人卡脖子。纵观国内外,有很多这样鲜活的例子,当自己弱小时,会先选择使用别家的产品,当自己羽翼丰满时,再选择自建完善自己的生态圈。但是一些旧版的kafka仍需配置ZooKeeper服务,因为Kafka依赖ZooKeeper进行集群协调、Broker注册、Topic管理等操作。安装ZooKeeperJava环境ZooKeeper是基于Java开发的,因此在部署时需要确保机器上有Java运行环境(JRE/JDK)。检查当前 Java 环境首先确认系统是否已安装 Java,以及版本是否符合要求java -version openjdk version "25.0.1" 2025-10-21 OpenJDK Runtime Environment (build 25.0.1+8-Ubuntu-124.04) OpenJDK 64-Bit Server VM (build 25.0.1+8-Ubuntu-124.04, mixed mode, sharing)若提示 command not found,说明未安装 Java,需继续安装java -version 找不到命令 “java”,但可以通过以下软件包安装它: apt install openjdk-17-jre-headless # version 17.0.17+10-1~24.04, or apt install openjdk-21-jre-headless # version 21.0.9+10-1~24.04 apt install default-jre # version 2:1.17-75 apt install openjdk-19-jre-headless # version 19.0.2+7-4 apt install openjdk-20-jre-headless # version 20.0.2+9-1 apt install openjdk-22-jre-headless # version 22~22ea-1 apt install openjdk-11-jre-headless # version 11.0.29+7-1ubuntu1~24.04 apt install openjdk-25-jre-headless # version 25.0.1+8-1~24.04 apt install openjdk-8-jre-headless # version 8u472-ga-1~24.04 root@zookeeper1:~/zookeeper# apt install openjdk-11-jre-headless 正在读取软件包列表... 完成 正在分析软件包的依赖关系树... 完成 正在读取状态信息... 完成 将会同时安装下列软件: alsa-topology-conf alsa-ucm-conf ca-certificates-java java-common libasound2-data libasound2t64 建议安装: default-jre alsa-utils libasound2-plugins libnss-mdns fonts-dejavu-extra fonts-ipafont-gothic fonts-ipafont-mincho fonts-wqy-microhei | fonts-wqy-zenhei fonts-indic下载并解压ZooKeeper点击 ZooKeeper下载列表 ,下载最新版本的安装包。wget -O zookeeper-3.9.4-bin.tar.gz https://dlcdn.apache.org/zookeeper/zookeeper-3.9.4/apache-zookeeper-3.9.4-bin.tar.gz tar -xf zookeeper-3.9.4-bin.tar.gz mv apache-zookeeper-3.9.4-bin/ /opt/zookeeper注意:集群模式至少需要三台服务器,强烈建议拥有奇数台服务器。如果你只有两台服务器,那么如果其中一台故障,机器数量不足以形成多数法定人数。两台服务器本质上比单台服务器稳定性差,因为存在两个单点故障。配置所有的服务器都拥有相同的配置文件。在ZooKeeper目录下的conf目录中,有个配置文件的示例,拷贝这个文件并修改其中的部分内容cp conf/zoo_sample.cfg conf/zoo.cfg修改项:tickTime=2000 initLimit=10 syncLimit=5 dataDir=/var/zookeeper/data dataLogDir=/var/zookeeper/logs clientPort=2181 server.1=192.168.88.31:2888:3888 server.2=192.168.88.32:2888:3888 server.3=192.168.88.33:2888:3888说明:tickTime:ZooKeeper 使用的基本时间单位(毫秒)。它用于读取心跳,最小会话超时时间是tickTime的两倍。initLimit:用来限制法定人数服务器连接领导者所需时间的超时syncLimit:限制服务器与领导者的过时距离dataDir:存储内存数据库快照的位置,除非另有说明,存储数据库更新的事务日志。dataLogDir:存储日志文件的位置clientPort:用于监听客户端连接的端口server.1=192.168.88.31:2888:3888 集群地址,“2888”和“3888”。对等节点使用前一个端口连接其他节点。这种连接是必要的,以便对等端能够通信,例如达成更新顺序的一致。更具体地说,ZooKeeper服务器利用该端口将追随者连接到领导者。当出现新的领导者时,跟随者会通过该端口与该领导者开启TCP连接。由于默认领导人选举也使用TCP,我们目前要求领导人选举需要另一个端口。这是服务器条目的第二个端口。确保dataDir和dataLogDir目录存在,如果不存在就创建它们。配置myid 在data/目录下,按集群顺序依次创建myid文件并写入id信息。#88.31机器上 echo 1 >myid #88.32机器上 echo 2 >myid #88.33机器上 echo 3 >myid开启服务bin/zkServer.sh start /usr/bin/java ZooKeeper JMX enabled by default Using config: /root/zookeeper/bin/../conf/zoo.cfg Starting zookeeper ... STARTED root@zookeeper2:~/zookeeper# bin/zkServer.sh status /usr/bin/java ZooKeeper JMX enabled by default Using config: /root/zookeeper/bin/../conf/zoo.cfg Client port found: 2181. Client address: localhost. Client SSL: false. Mode: leader 配置开机启动(service服务)vim /etc/systemd/system/zookeeper.service [Unit] Description=Apache ZooKeeper Service Documentation=https://zookeeper.apache.org After=network.target [Service] Type=forking ExecStart=/root/zookeeper/bin/zkServer.sh start ExecStop=/root/zookeeper/bin/zkServer.sh stop ExecReload=/root/zookeeper/bin/zkServer.sh restart Restart=on-failure [Install] WantedBy=multi-user.target systemctl daemon-reload systemctl enable zookeeper --now -

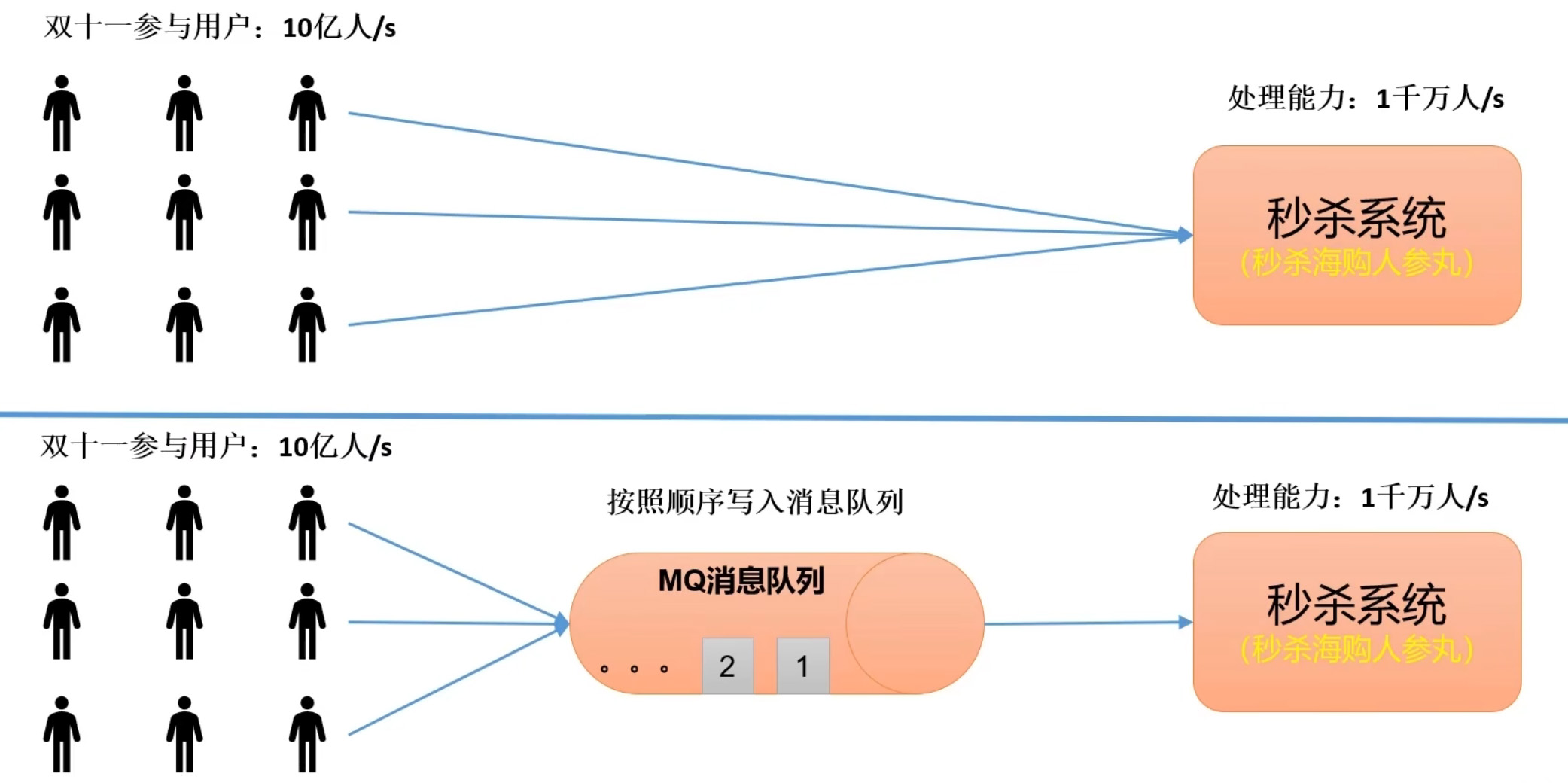

Kafka——Kafka概述 Kafka定义kafka传统定义:Kafka是一个分布式的基于发布/订阅模式的消息列队(Message Queue),主要应用于大数据实时处理领域。发布/订阅:消息的发布者不会将消息直接发送给特定的订阅者,而是将发布的消息分为不同的类别,订阅者只接收感兴趣的消息。Kafka最新定义:Kafka是一个开源的 分布式事件流平台 (Event Streaming Platform),用于高性能 数据管道、流分析、数据集成和关键任务应用 。消息队列目前企业中比较常见的消息列队产品有Kafka、ActiveMQ、RabbitMQ、RocketMQ等。在大数据场景主要采用Kafka作为消息列队。在JavaEE开发中主要采用ActiveMQ、RabbitMQ、RocketMQ。传统消息列队的应用场景主要应用场景包括:缓冲/消峰、解耦和异步通信。缓冲/消峰有助于控制和优化数据流经过系统的速度,解决生产消息和消费消息的处理速度不一致的情况。解耦允许独立的扩展或修改两边的处理过程,只需要确保它们遵守同样的接口约束。异步通信允许用户把一个消息放入队列,但并不立即处理它,然后在需要的时候再去处理它们。消息列队的两种模式1.点对点模式:消费者主动拉取数据,消息收到后清除消息2.发布/订阅模式:可以有多个topic主题(浏览、点赞、收藏、评论等)消费者消费数据之后,不删除数据每个消费者相互独立,都可以消费到数据Kafka特点数据吞吐量巨大:需要能够快速收集各个渠道的海量日志集群容错性高:允许集群内少量节点崩溃功能不需要太复杂:kafka的设计目标算高吞吐量、低延迟和可扩展性,主要关注消息传递而不是消息处理,所以kafka没有支持死信列队、顺序消息等高级功能允许少量数据丢失:在海量的应用日志中,少量的日志丢失算不会影响结果的。所以kafka的设计初衷算允许少量数据丢失的。当然,kafka本身也在不断优化数据安全问题。Kafka基础架构为方便扩展,提高吞吐量,一个topic分为多个partition配合分区的设计,提出消费者组的概念,组内每个消费者并行消费为提高可用性,为每个partition增加若干副本,类似NameNode HAZK中记录谁是leader,Kafka.8.0以后可以配置不采用ZKProducer:消息生产者,向Kafka broker发消息的客户端Consumer:消息消费者,向Kafka broker拉取消息的客户端Topic:主题,存储各种各样的数据注:一个分区的数据只能由一个消费者来消费。

Kafka——Kafka概述 Kafka定义kafka传统定义:Kafka是一个分布式的基于发布/订阅模式的消息列队(Message Queue),主要应用于大数据实时处理领域。发布/订阅:消息的发布者不会将消息直接发送给特定的订阅者,而是将发布的消息分为不同的类别,订阅者只接收感兴趣的消息。Kafka最新定义:Kafka是一个开源的 分布式事件流平台 (Event Streaming Platform),用于高性能 数据管道、流分析、数据集成和关键任务应用 。消息队列目前企业中比较常见的消息列队产品有Kafka、ActiveMQ、RabbitMQ、RocketMQ等。在大数据场景主要采用Kafka作为消息列队。在JavaEE开发中主要采用ActiveMQ、RabbitMQ、RocketMQ。传统消息列队的应用场景主要应用场景包括:缓冲/消峰、解耦和异步通信。缓冲/消峰有助于控制和优化数据流经过系统的速度,解决生产消息和消费消息的处理速度不一致的情况。解耦允许独立的扩展或修改两边的处理过程,只需要确保它们遵守同样的接口约束。异步通信允许用户把一个消息放入队列,但并不立即处理它,然后在需要的时候再去处理它们。消息列队的两种模式1.点对点模式:消费者主动拉取数据,消息收到后清除消息2.发布/订阅模式:可以有多个topic主题(浏览、点赞、收藏、评论等)消费者消费数据之后,不删除数据每个消费者相互独立,都可以消费到数据Kafka特点数据吞吐量巨大:需要能够快速收集各个渠道的海量日志集群容错性高:允许集群内少量节点崩溃功能不需要太复杂:kafka的设计目标算高吞吐量、低延迟和可扩展性,主要关注消息传递而不是消息处理,所以kafka没有支持死信列队、顺序消息等高级功能允许少量数据丢失:在海量的应用日志中,少量的日志丢失算不会影响结果的。所以kafka的设计初衷算允许少量数据丢失的。当然,kafka本身也在不断优化数据安全问题。Kafka基础架构为方便扩展,提高吞吐量,一个topic分为多个partition配合分区的设计,提出消费者组的概念,组内每个消费者并行消费为提高可用性,为每个partition增加若干副本,类似NameNode HAZK中记录谁是leader,Kafka.8.0以后可以配置不采用ZKProducer:消息生产者,向Kafka broker发消息的客户端Consumer:消息消费者,向Kafka broker拉取消息的客户端Topic:主题,存储各种各样的数据注:一个分区的数据只能由一个消费者来消费。 -

kubectl常用命令 集群信息显示 Kubernetes 版本:kubectl version显示集群信息:kubectl cluster-info列出集群中的所有节点:kubectl get node查看一个具体的节点详情:kubectl describe node <node-name>5.列出所有命名空间:kubectl get namespaces列出所有命名空间中的所有 pod:kubectl get pods --all-namespacesPod信息列出特定命名空间中的 pod:kubectl get pods -n <namespace>查看一个 Pod 详情:kubectl describe pod <pod-name> -n <namespace>查看 Pod 日志:kubectl logs <pod-name> -n <namespace>尾部 Pod 日志:kubectl logs -f <pod-name> -n <namespace>在 pod 中执行命令:kubectl exec -it <pod-name> -n <namespace> -- <command>Pod 亲和性和反亲和性列出 pod 的 pod 亲和性规则:kubectl get pod <pod-name> -n <namespace> -o=jsonpath='{.spec.affinity}'列出 pod 的 pod 反亲和性规则:kubectl get pod <pod-name> -n <namespace> -o=jsonpath='{.spec.affinity.podAntiAffinity}'节点污点 列出节点污点:kubectl describe node <node-name> | grep TaintsPod 优先级和抢占 列出优先级:kubectl get priorityclassesPod 开销 列出 pod 中的开销:kubectl get pod <pod-name> -n <namespace> -o=jsonpath='{.spec.overhead}'Pod 健康检查检查 Pod 准备情况:kubectl get pods <pod-name> -n <namespace> -o jsonpath='{.status.conditions[?(@.type=="Ready")].status}'检查 Pod 事件:kubectl get events -n <namespace> --field-selector involvedObject.name=<pod-name>服务信息Service信息列出命名空间中的所有服务:kubectl get svc -n <namespace>查看一个服务详情:kubectl describe svc <service-name> -n <namespace>更改和验证 Webhook 配置列出变异 webhook 配置:kubectl get mutatingwebhookconfigurations列出验证 Webhook 配置:kubectl get validatingwebhookconfigurationsPod 网络策略 列出命名空间中的 pod 网络策略:kubectl get networkpolicies -n <namespace>部署相关Deployment信息列出命名空间中的所有Deployment:kubectl get deployments -n <namespace>查看一个Deployment详情:kubectl describe deployment <deployment-name> -n <namespace>查看滚动发布状态:kubectl rollout status deployment/<deployment-name> -n <namespace>查看滚动发布历史记录:kubectl rollout history deployment/<deployment-name> -n <namespace>作业和 CronJob列出命名空间中的所有作业:kubectl get jobs -n <namespace>查看一份工作详情:kubectl describe job <job-name> -n <namespace>列出命名空间中的所有 cron 作业:kubectl get cronjobs -n <namespace>查看一个 cron 作业详情:kubectl describe cronjob <cronjob-name> -n <namespace>StatefulSet信息列出命名空间中的所有 StatefulSet:kubectl get statefulsets -n <namespace>查看一个 StatefulSet详情:kubectl describe statefulset <statefulset-name> -n <namespace>ConfigMap 和Secret信息列出命名空间中的 ConfigMap:kubectl get configmaps -n <namespace>查看一个ConfigMap详情:kubectl describe configmap <configmap-name> -n <namespace>列出命名空间中的 Secret:kubectl get secrets -n <namespace>查看一个Secret详情:kubectl describe secret <secret-name> -n <namespace>命名空间信息查看一个命名空间详情:kubectl describe namespace <namespace-name>资源使用情况检查 pod 的资源使用情况:kubectl top pod <pod-name> -n <namespace>检查节点资源使用情况:kubectl top nodes持久卷和持久卷声明列出PV:kubectl get pv查看一个PV详情:kubectl describe pv <pv-name>列出命名空间中的 PVC:kubectl get pvc -n <namespace>查看PVC详情:kubectl describe pvc <pvc-name> -n <namespace>容量信息列出按容量排序的持久卷 (PV):kubectl get pv --sort-by=.spec.capacity.storage查看PV回收策略:kubectl get pv <pv-name> -o=jsonpath='{.spec.persistentVolumeReclaimPolicy}'列出所有存储类别:kubectl get storageclasses存储卷快照列出存储卷快照:kubectl get volumesnapshot -n <namespace>查看存储卷快照详情:kubectl describe volumesnapshot <snapshot-name> -n <namespace>资源反序列化 反序列化并打印 Kubernetes 资源:kubectl get <resource-type> <resource-name> -n <namespace> -o=json网络信息显示命名空间中 Pod 的 IP 地址:kubectl get pods -n <namespace> -o custom-columns=POD:metadata.name,IP:status.podIP --no-headers列出命名空间中的所有网络策略:kubectl get networkpolicies -n <namespace>查看一个网络策略详情:kubectl describe networkpolicy <network-policy-name> -n <namespace>Ingress和服务网格列出命名空间中的所有Ingress:kubectl get ingress -n <namespace>查看一个Ingress详情:kubectl describe ingress <ingress-name> -n <namespace>列出命名空间中的所有 VirtualServices (Istio):kubectl get virtualservices -n <namespace>查看一个 VirtualService (Istio)详情:kubectl describe virtualservice <virtualservice-name> -n <namespace>节点诊断获取特定节点上运行的 Pod 列表:kubectl get pods --field-selector spec.nodeName=<node-name> -n <namespace>Pod 网络故障排除运行网络诊断 Pod(例如 busybox)进行调试:kubectl run -it --rm --restart=Never --image=busybox net-debug-pod -- /bin/bash测试从 Pod 到特定端点的连接:kubectl exec -it <pod-name> -n <namespace> -- curl <endpoint-url>跟踪从一个 Pod 到另一个 Pod 的网络路径:kubectl exec -it <source-pod-name> -n <namespace> -- traceroute <destination-pod-ip>检查 Pod 的 DNS 解析:kubectl exec -it <pod-name> -n <namespace> -- nslookup <domain-name>资源使用情况资源配额和限制列出命名空间中的资源配额:kubectl get resourcequotas -n <namespace>查看一个资源配额详情:kubectl describe resourcequota <resource-quota-name> -n <namespace>自定义资源定义 (CRD)列出命名空间中的自定义资源:kubectl get <custom-resource-name> -n <namespace>查看自定义资源详情:kubectl describe <custom-resource-name> <custom-resource-instance-name> -n <namespace>使用这些命令时,请记住将<namespace>, <pod-name>, <service-name>, <deployment-name>, <statefulset-name>, <configmap-name>, <secret-name>, <namespace-name>, <pv-name>, <pvc-name>, <node-name>, <network-policy-name>, <resource-quota-name>, <custom-resource-name>, 和替换为你的特定值。<custom-resource-instance-name>这些命令应该可以帮助你诊断 Kubernetes 集群以及在其中运行的应用程序。资源伸缩和自动伸缩Deployment伸缩:kubectl scale deployment <deployment-name> --replicas=<replica-count> -n <namespace>设置Deployment的自动伸缩:kubectl autoscale deployment <deployment-name> --min=<min-pods> --max=<max-pods> --cpu-percent=<cpu-percent> -n <namespace>检查水平伸缩器状态:kubectl get hpa -n <namespace>配置和资源验证验证 Kubernetes YAML 文件而不应用它:kubectl apply --dry-run=client -f <yaml-file>验证 pod 的安全上下文和功能:kubectl auth can-i list pods --as=system:serviceaccount:<namespace>:<serviceaccount-name>安全和授权RBAC和安全性列出命名空间中的角色和角色绑定:kubectl get roles,rolebindings -n <namespace>查看角色或角色绑定详情:kubectl describe role <role-name> -n <namespace>Pod 安全策略 (PSP) 列出所有 Pod 安全策略(如果启用):kubectl get psp事件:查看最近的集群事件:kubectl get events --sort-by=.metadata.creationTimestamp按特定命名空间过滤事件:kubectl get events -n <namespace>Pod 安全标准(PodSecurity 准入控制器) 列出 PodSecurityPolicy (PSP) 违规行为:kubectl get psp -A | grep -vE 'NAME|REVIEWED'服务帐户列出命名空间中的服务帐户:kubectl get serviceaccounts -n <namespace>查看一个服务帐户详情:kubectl describe serviceaccount <serviceaccount-name> -n <namespace>清空节点和解除封锁清空节点以进行维护:kubectl drain <node-name> --ignore-daemonsets解除对节点的封锁:kubectl uncordon <node-name>资源清理强制删除 pod(不推荐):kubectl delete pod <pod-name> -n <namespace> --grace-period=0 --force节点故障排除检查节点情况:kubectl describe node <node-name> | grep Conditions -A5列出节点容量和可分配资源:kubectl describe node <node-name> | grep -E "Capacity|Allocatable"临时容器 运行临时调试容器:kubectl debug -it <pod-name> -n <namespace> --image=<debug-image> -- /bin/sh资源指标 获取 Pod 的 CPU 和内存使用情况:kubectl top pod -n <namespace>kuelet诊断 查看节点上的kubelet日志:kubectl logs -n kube-system kubelet-<node-name>使用Telepresence 进行高级调试 使用 Telepresence 调试 pod:telepresence --namespace <namespace> --swap-deployment <pod-name>Kubeconfig 和上下文列出可用的上下文:kubectl config get-contexts切换到不同的上下文:kubectl config use-context <context-name>Pod 中断预算 (PDB)列出命名空间中的所有 PDB:kubectl get pdb -n <namespace>查看一个PDB详情:kubectl describe pdb <pdb-name> -n <namespace>资源锁诊断(如果使用资源锁)列出服务的服务端点:kubectl get endpoints <service-name> -n <namespace>检查 Pod 中的 DNS 配置:kubectl exec -it <pod-name> -n <namespace> -- cat /etc/resolv.conf自定义指标(Prometheus、Grafana) 查询Prometheus指标:用于kubectl port-forward访问Prometheus和Grafana服务来查询自定义指标。节点条件 自定义查询输出:kubectl get nodes -o custom-columns=NODE:.metadata.name,READY:.status.conditions[?(@.type=="Ready")].status -l 'node-role.kubernetes.io/worker='审核日志 检索审核日志(如果启用):检查 Kubernetes 审核日志配置以了解审核日志的位置。节点操作系统详细信息获取节点的操作系统信息:kubectl get node <node-name> -o jsonpath='{.status.nodeInfo.osImage}'这些命令应该涵盖 Kubernetes 中的各种诊断场景。确保将、、等占位符替换为集群和用例的实际值。其他诊断命令

kubectl常用命令 集群信息显示 Kubernetes 版本:kubectl version显示集群信息:kubectl cluster-info列出集群中的所有节点:kubectl get node查看一个具体的节点详情:kubectl describe node <node-name>5.列出所有命名空间:kubectl get namespaces列出所有命名空间中的所有 pod:kubectl get pods --all-namespacesPod信息列出特定命名空间中的 pod:kubectl get pods -n <namespace>查看一个 Pod 详情:kubectl describe pod <pod-name> -n <namespace>查看 Pod 日志:kubectl logs <pod-name> -n <namespace>尾部 Pod 日志:kubectl logs -f <pod-name> -n <namespace>在 pod 中执行命令:kubectl exec -it <pod-name> -n <namespace> -- <command>Pod 亲和性和反亲和性列出 pod 的 pod 亲和性规则:kubectl get pod <pod-name> -n <namespace> -o=jsonpath='{.spec.affinity}'列出 pod 的 pod 反亲和性规则:kubectl get pod <pod-name> -n <namespace> -o=jsonpath='{.spec.affinity.podAntiAffinity}'节点污点 列出节点污点:kubectl describe node <node-name> | grep TaintsPod 优先级和抢占 列出优先级:kubectl get priorityclassesPod 开销 列出 pod 中的开销:kubectl get pod <pod-name> -n <namespace> -o=jsonpath='{.spec.overhead}'Pod 健康检查检查 Pod 准备情况:kubectl get pods <pod-name> -n <namespace> -o jsonpath='{.status.conditions[?(@.type=="Ready")].status}'检查 Pod 事件:kubectl get events -n <namespace> --field-selector involvedObject.name=<pod-name>服务信息Service信息列出命名空间中的所有服务:kubectl get svc -n <namespace>查看一个服务详情:kubectl describe svc <service-name> -n <namespace>更改和验证 Webhook 配置列出变异 webhook 配置:kubectl get mutatingwebhookconfigurations列出验证 Webhook 配置:kubectl get validatingwebhookconfigurationsPod 网络策略 列出命名空间中的 pod 网络策略:kubectl get networkpolicies -n <namespace>部署相关Deployment信息列出命名空间中的所有Deployment:kubectl get deployments -n <namespace>查看一个Deployment详情:kubectl describe deployment <deployment-name> -n <namespace>查看滚动发布状态:kubectl rollout status deployment/<deployment-name> -n <namespace>查看滚动发布历史记录:kubectl rollout history deployment/<deployment-name> -n <namespace>作业和 CronJob列出命名空间中的所有作业:kubectl get jobs -n <namespace>查看一份工作详情:kubectl describe job <job-name> -n <namespace>列出命名空间中的所有 cron 作业:kubectl get cronjobs -n <namespace>查看一个 cron 作业详情:kubectl describe cronjob <cronjob-name> -n <namespace>StatefulSet信息列出命名空间中的所有 StatefulSet:kubectl get statefulsets -n <namespace>查看一个 StatefulSet详情:kubectl describe statefulset <statefulset-name> -n <namespace>ConfigMap 和Secret信息列出命名空间中的 ConfigMap:kubectl get configmaps -n <namespace>查看一个ConfigMap详情:kubectl describe configmap <configmap-name> -n <namespace>列出命名空间中的 Secret:kubectl get secrets -n <namespace>查看一个Secret详情:kubectl describe secret <secret-name> -n <namespace>命名空间信息查看一个命名空间详情:kubectl describe namespace <namespace-name>资源使用情况检查 pod 的资源使用情况:kubectl top pod <pod-name> -n <namespace>检查节点资源使用情况:kubectl top nodes持久卷和持久卷声明列出PV:kubectl get pv查看一个PV详情:kubectl describe pv <pv-name>列出命名空间中的 PVC:kubectl get pvc -n <namespace>查看PVC详情:kubectl describe pvc <pvc-name> -n <namespace>容量信息列出按容量排序的持久卷 (PV):kubectl get pv --sort-by=.spec.capacity.storage查看PV回收策略:kubectl get pv <pv-name> -o=jsonpath='{.spec.persistentVolumeReclaimPolicy}'列出所有存储类别:kubectl get storageclasses存储卷快照列出存储卷快照:kubectl get volumesnapshot -n <namespace>查看存储卷快照详情:kubectl describe volumesnapshot <snapshot-name> -n <namespace>资源反序列化 反序列化并打印 Kubernetes 资源:kubectl get <resource-type> <resource-name> -n <namespace> -o=json网络信息显示命名空间中 Pod 的 IP 地址:kubectl get pods -n <namespace> -o custom-columns=POD:metadata.name,IP:status.podIP --no-headers列出命名空间中的所有网络策略:kubectl get networkpolicies -n <namespace>查看一个网络策略详情:kubectl describe networkpolicy <network-policy-name> -n <namespace>Ingress和服务网格列出命名空间中的所有Ingress:kubectl get ingress -n <namespace>查看一个Ingress详情:kubectl describe ingress <ingress-name> -n <namespace>列出命名空间中的所有 VirtualServices (Istio):kubectl get virtualservices -n <namespace>查看一个 VirtualService (Istio)详情:kubectl describe virtualservice <virtualservice-name> -n <namespace>节点诊断获取特定节点上运行的 Pod 列表:kubectl get pods --field-selector spec.nodeName=<node-name> -n <namespace>Pod 网络故障排除运行网络诊断 Pod(例如 busybox)进行调试:kubectl run -it --rm --restart=Never --image=busybox net-debug-pod -- /bin/bash测试从 Pod 到特定端点的连接:kubectl exec -it <pod-name> -n <namespace> -- curl <endpoint-url>跟踪从一个 Pod 到另一个 Pod 的网络路径:kubectl exec -it <source-pod-name> -n <namespace> -- traceroute <destination-pod-ip>检查 Pod 的 DNS 解析:kubectl exec -it <pod-name> -n <namespace> -- nslookup <domain-name>资源使用情况资源配额和限制列出命名空间中的资源配额:kubectl get resourcequotas -n <namespace>查看一个资源配额详情:kubectl describe resourcequota <resource-quota-name> -n <namespace>自定义资源定义 (CRD)列出命名空间中的自定义资源:kubectl get <custom-resource-name> -n <namespace>查看自定义资源详情:kubectl describe <custom-resource-name> <custom-resource-instance-name> -n <namespace>使用这些命令时,请记住将<namespace>, <pod-name>, <service-name>, <deployment-name>, <statefulset-name>, <configmap-name>, <secret-name>, <namespace-name>, <pv-name>, <pvc-name>, <node-name>, <network-policy-name>, <resource-quota-name>, <custom-resource-name>, 和替换为你的特定值。<custom-resource-instance-name>这些命令应该可以帮助你诊断 Kubernetes 集群以及在其中运行的应用程序。资源伸缩和自动伸缩Deployment伸缩:kubectl scale deployment <deployment-name> --replicas=<replica-count> -n <namespace>设置Deployment的自动伸缩:kubectl autoscale deployment <deployment-name> --min=<min-pods> --max=<max-pods> --cpu-percent=<cpu-percent> -n <namespace>检查水平伸缩器状态:kubectl get hpa -n <namespace>配置和资源验证验证 Kubernetes YAML 文件而不应用它:kubectl apply --dry-run=client -f <yaml-file>验证 pod 的安全上下文和功能:kubectl auth can-i list pods --as=system:serviceaccount:<namespace>:<serviceaccount-name>安全和授权RBAC和安全性列出命名空间中的角色和角色绑定:kubectl get roles,rolebindings -n <namespace>查看角色或角色绑定详情:kubectl describe role <role-name> -n <namespace>Pod 安全策略 (PSP) 列出所有 Pod 安全策略(如果启用):kubectl get psp事件:查看最近的集群事件:kubectl get events --sort-by=.metadata.creationTimestamp按特定命名空间过滤事件:kubectl get events -n <namespace>Pod 安全标准(PodSecurity 准入控制器) 列出 PodSecurityPolicy (PSP) 违规行为:kubectl get psp -A | grep -vE 'NAME|REVIEWED'服务帐户列出命名空间中的服务帐户:kubectl get serviceaccounts -n <namespace>查看一个服务帐户详情:kubectl describe serviceaccount <serviceaccount-name> -n <namespace>清空节点和解除封锁清空节点以进行维护:kubectl drain <node-name> --ignore-daemonsets解除对节点的封锁:kubectl uncordon <node-name>资源清理强制删除 pod(不推荐):kubectl delete pod <pod-name> -n <namespace> --grace-period=0 --force节点故障排除检查节点情况:kubectl describe node <node-name> | grep Conditions -A5列出节点容量和可分配资源:kubectl describe node <node-name> | grep -E "Capacity|Allocatable"临时容器 运行临时调试容器:kubectl debug -it <pod-name> -n <namespace> --image=<debug-image> -- /bin/sh资源指标 获取 Pod 的 CPU 和内存使用情况:kubectl top pod -n <namespace>kuelet诊断 查看节点上的kubelet日志:kubectl logs -n kube-system kubelet-<node-name>使用Telepresence 进行高级调试 使用 Telepresence 调试 pod:telepresence --namespace <namespace> --swap-deployment <pod-name>Kubeconfig 和上下文列出可用的上下文:kubectl config get-contexts切换到不同的上下文:kubectl config use-context <context-name>Pod 中断预算 (PDB)列出命名空间中的所有 PDB:kubectl get pdb -n <namespace>查看一个PDB详情:kubectl describe pdb <pdb-name> -n <namespace>资源锁诊断(如果使用资源锁)列出服务的服务端点:kubectl get endpoints <service-name> -n <namespace>检查 Pod 中的 DNS 配置:kubectl exec -it <pod-name> -n <namespace> -- cat /etc/resolv.conf自定义指标(Prometheus、Grafana) 查询Prometheus指标:用于kubectl port-forward访问Prometheus和Grafana服务来查询自定义指标。节点条件 自定义查询输出:kubectl get nodes -o custom-columns=NODE:.metadata.name,READY:.status.conditions[?(@.type=="Ready")].status -l 'node-role.kubernetes.io/worker='审核日志 检索审核日志(如果启用):检查 Kubernetes 审核日志配置以了解审核日志的位置。节点操作系统详细信息获取节点的操作系统信息:kubectl get node <node-name> -o jsonpath='{.status.nodeInfo.osImage}'这些命令应该涵盖 Kubernetes 中的各种诊断场景。确保将、、等占位符替换为集群和用例的实际值。其他诊断命令